タイトル: 『言語生成・学習モデルについてのメモ』 2022年11月、ChatGPT 3.5が登場しました。このモデルは生成モデルの一翼を担い、拡散モデルとして注目を集めました。さらに、マイクロソフトがOpenAIに数千億円を投資するなど、技術の進展と資金投入が相次いでいます。 GAFAM(Google, Apple, Facebook, Amazon, Microsoft)や中国のBATH(Baidu, Alibaba, Tencent, Huawei)など、大手テック企業がAI分野で競争を繰り広げています。 幻覚やハルシネーションの研究が進む一方、執筆にもLanguage Learning Model(LLM)が活用されています。LLMは文章生成の伴走者として、幅広い分野で活躍しています。 論理的な演繹と具体的な帰納の違いや、破滅的忘却という概念など、知識の整理が行われています。価値観や偏見を排除するためにも、注意が払われていますが、同時に生成技術の進化により偽情報の時代も到来しています。 AIの目標駆動学習や、1990年代後半の機械学習の高速化、教師あり学習から強化学習への移行など、学習方法の進化が歴史的に振り返られています。シャノンの情報理論に基づく学習方法や、言語モデルの確率的な文生成能力も解説されています。 自己教師あり学習を通じて文章の生成や補完を行うトレーニング方法が述べられ、言語の内部表現に迫る試みも行われています。汎化と過学習の説明を通じて、モデルの性能と安定性に関する洞察が提供されています。 データ圧縮や確率分布の推定などの要素が挙げられ、LLMは特に圧縮性に優れるモデルを求める方向性が示されています。また、2014年には画像生成においてニューラルネットワークと生成モデルの組み合わせが注目され、AIの進化が多岐にわたることが示されています。 学習のべき乗則が発見され、学習の効率や性能を予測する上での指針となっています。これにより、モデルの性能評価がより効果的に行えるようになりました。プロンプトエンジニアリングやゼロショット学習といったアプローチが、モデルの汎用性向上に寄与しています。 2022年5月にはPaLM(Parameter-efficient Language Model)が登場し、高額な学習コストにもかかわらず、数億パラメータのモデルが訓練されています。学習に関するコスト削減策として専用のハードウェアチップの開発も進んでいます。 モデルの予測性能はべき乗則に従いつつ、タスク解決にはパラメータ増加が突破口を開くことが明らかになっています。現代のモデルは1兆パラメータを超える規模に成長し、その驚異的な能力が示されています。 Transformerの注意機構や倫理的な側面への取り組み、ReLU関数や誤差逆伝播法、正則化手法などの技術的な要素にも触れられています。AIの進化は画像生成やゲームプレイだけでなく、タンパク質の構造予測などの生命科学分野にも貢献しています。 大規模なニューラルネットワークは局所最適解に陥りにくい性質を持ち、確率的勾配降下法が学習手法として有用であることが説明されています。最終的なモデルは平坦な最小解に収束し、そのシンプルな構造が高い汎用性を保証しています。 Transformerモデルにおける短期記憶と長期記憶の扱い、学習のステップバイステップなプロセス、メタ学習や分布外汎化への取り組みなどが詳しく説明されています。また、LLMが知識を補完する伴走者として活躍する様子が描かれています。 将来に向けて、人工知能が人間を超越する場面が増えても、楽しみながら共存する姿勢が示唆されています。学習データの正確さや適切な運用のための法整備の重要性も強調されています。企業としてもPFN(Preferred Networks)やAI研究者の岡野原大輔氏のような存在が、技術の前進に貢献しています。 メモ内容を基に、ブログ用の文章にアレンジいたしました。内容の確認や修正があればお知らせください。

support page

以降、章ごとのメモや思ったことを混ぜて書く(目次併記)

0, 1

序章 チャットGPTがもたらした衝撃

登場から二カ月で月間一億人が利用するサービスに

大規模言語モデルはこれまでにない汎用サービスを実現する

生活や社会を変えうる

社会への脅威となりうる

言語獲得の謎は解けるのか

新しい知能との付き合い方

1 大規模言語モデルはどんなことを可能にするだろうか

文書の校正・要約・翻訳

プログラミングのサポート

ウェブ検索エンジンの上位互換

言語を使った作品を作る

言語以外を使った作品を作る

カウンセリング、コーチング

学習のサポート

高度な専門性が必要な仕事のサポート

人にやさしいインターフェース

科学研究の加速

演繹的なアプローチと帰納的なアプローチの融合

2, 3

2 巨大なリスクと課題

情報の信憑性――幻覚

幻覚の解決は簡単ではない

誤った情報の拡散

プライベートな領域に入り込む

価値観や偏見の扱い方

本人であることの証明が難しくなる

変わる仕事、残る仕事

AIの補助で仕事の構造が変わっていく

大規模言語モデルの開発が一部に独占される

3 機械はなぜ人のように話せないのか

人は言語をどのように獲得し、運用しているのか

私たちは言語をいつのまにか獲得している

自然言語処理と機械学習

これまでの機械学習では言語獲得・運用は難しかった

4

4 シャノンの情報理論から大規模言語モデル登場前夜まで

意味をなくし確率を使って情報を表わす――革命的だったシャノンの情報理論

どの文がもっともらしいか――言語モデル

言語モデルは言語を生成することができる

消された単語を予測することで言語理解の能力を獲得する

多様な訓練データをタダでいくらでも入手できる自己教師あり学習

問題の背後にある法則やルールを理解できるか――汎化

実験結果は言語モデルが意味や構造を理解していることを示唆する

言語モデルは文の意味を理解し、かつ文も生成できる

《コラム》圧縮器としての言語モデル

データを生成できるモデルの発展

《コラム》人も言語モデルから学習しているのか

5

5 大規模言語モデルの登場

限界への挑戦

言語モデルの「べき乗則」の発見

データと計算力があれば知能が獲得できる

モデルを大きくすると問題が急に解けるようになる

《コラム》普遍文法と現在の大規模言語モデル

大規模化はどこまで進むのか

《コラム》人の脳とAI

プロンプトで変わるAIの使い方

AIを使った開発は誰でもできるようになる

人によるフィードバックを与える

6

6 大規模言語モデルはどのように動いているのか

ニューラルネットワークの進化

ニューラルネットワークの学習――誤差逆伝播法

汎化――未知のデータの予測へ

ディープラーニングの登場

《コラム》アレックスネット開発の裏側

なぜディープラーニングはここまで成功したのか

《コラム》モデルサイズと汎化の謎

データの流れ方を学習し、短期記憶を実現する注意機構

大規模言語モデルを実現したトランスフォーマー

指示を受け、その場で適応していく本文中学習

人間に寄り添う生成のための目標駆動学習

チャットGPTでの矯正法

終

終章 人は人以外の知能とどのように付き合うのか

道具としての大規模言語モデル

間違いもするし、自分と考え方も違う人のように付き合う

人はこうしたツールを飼いならせるのか

コンピュータ将棋、囲碁のケース

人間自身の理解へ

あとがき

その他、思ったこと

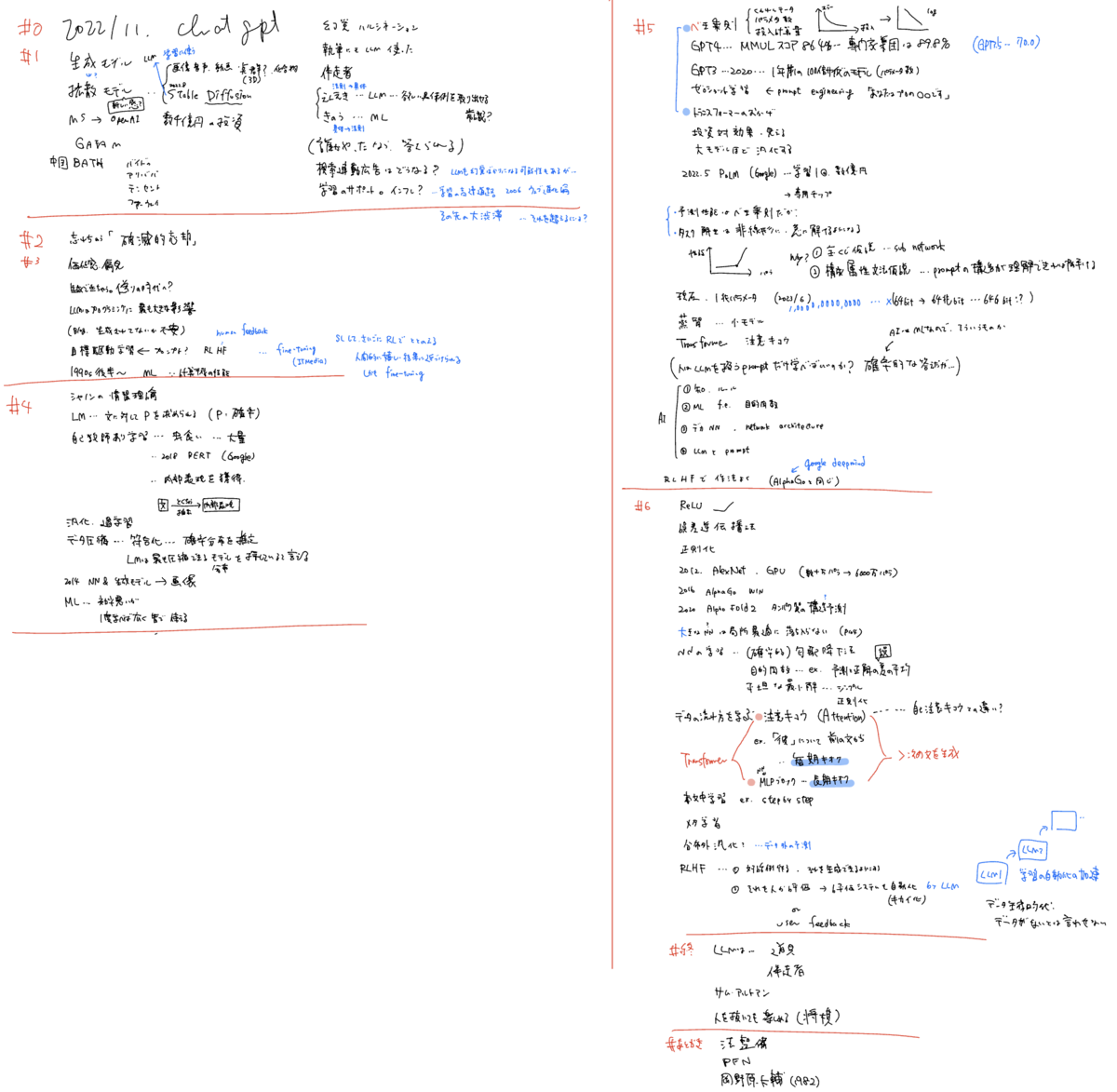

手書きメモ

おまけ:メモをテキスト化してgpt(3.5)に食わせてみた

input

以下にLLMについての本を読んだメモを書きます。ブログ用に書き直してください

===

2022/11 chatgpt3.5登場

生成モデルの一部として拡散モデル

マイクロソフトはOpenAIに数千億円の投資

GAFAM

中国BATH

幻覚 ハルシネーション

執筆にもLLM

LLMは伴走者

演繹と帰納

破滅的忘却

価値観・偏見を取り除くには

生成できちゃうので偽りの時代

目標駆動学習

1990年後半、高速化により機械学習

教師あり学習して、最後に強化学習

シャノンの情報学習

言語モデルは文に確率を求められる

自己教師あり学習として、一部を空にした文章の空欄を当てさせるトレーニング

言語の内部表現

汎化と過学習

データ圧縮、符号化、確率分布の推定

LLMは最も圧縮できるモデルを探している

2014 NN & 生成モデルで画像生成

機械学習は人間より学習の効率は悪いが、1度学べば皆で共有できる

学習のべき乗則が発見され、誤差と訓練データ、パラメータ数、投入計算量はべき乗則に従う

よって、学習前に性能を見積もれる

それはTransformerのおかげ

プロンプトエンジニアリングしたプロンプトを与えることでゼロショット学習

2022/5 PaLMによると学習1回で数億円

学習は高額になるので専用チップを作る会社も

予測性能はべき乗則に従うが、タスク解決はパラメータを増やすと突然解けるようになる

現在のモデルは1兆パラメータ

Transformerの注意機構

倫理を持ち、偏見がないようにするためのreinforcement learning by human feedback

ReLU関数

誤差逆伝播法

正則化

2012 AlexNet

2016 AlphaGo

2020 AlphaFold タンパク質の構造予測。クスリの開発に役立つ

大きなNNは局所最適に陥らない

NNの学習には確率的勾配降下法

平坦な最小解を見つけられたら、それはシンプルなモデルになっている

Transformerの短期記憶と長期記憶

本文中学習、step by step

メタ学習

分布外汎化

LLMは伴走者

サム・アルトマン

機械が人間を上回っても、将棋の評価値のように楽しむことができる

学習データの法整備

PFN

岡野原大輔 1982

output

感想